Backend

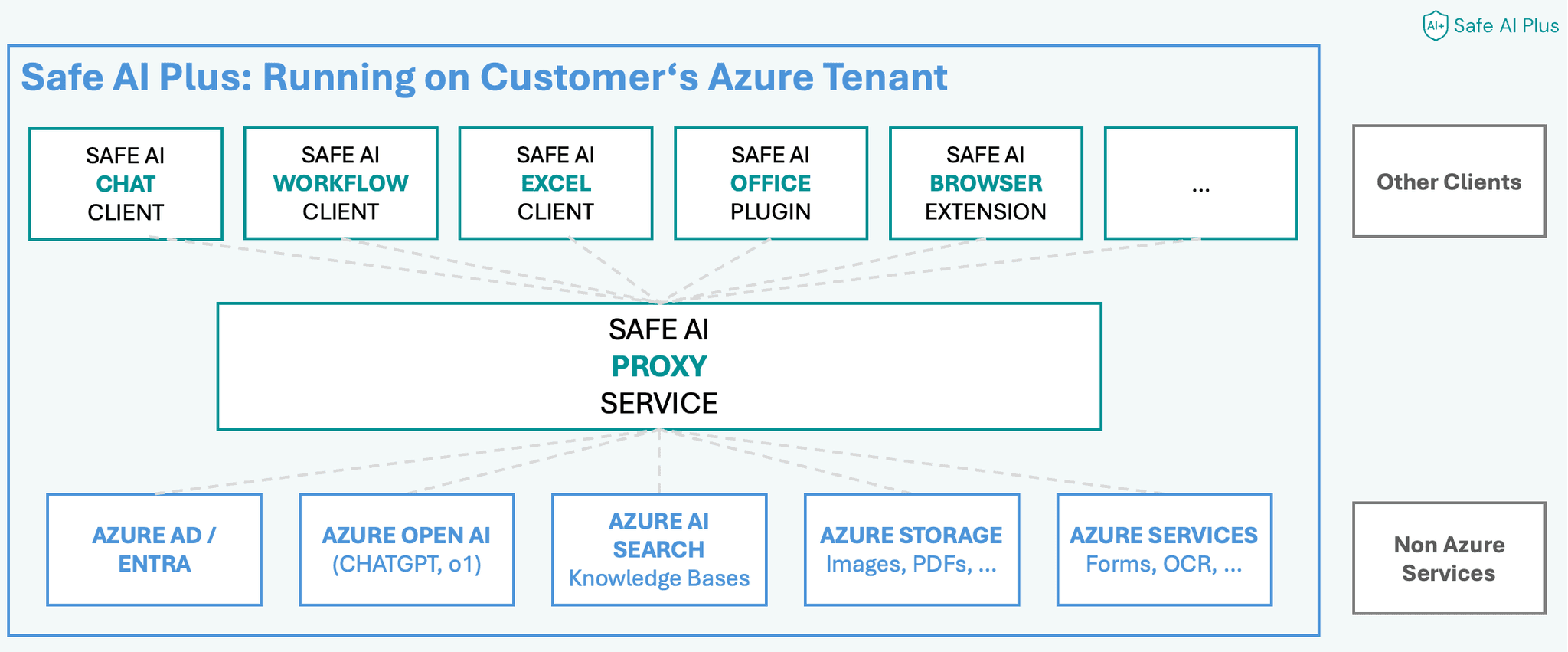

Das Safe AI Backend (Safe AI Proxy) ist aufgebaut aus verschiedenen Diensten, die durch den Proxy verwaltet werden.

Das Backend wird in der Azure Infrastruktur des Kunden installiert und durch den Kunden verwaltet und betrieben. Es können ebenfalls Dienste integriert werden, die nicht auf Azure basieren.

Architektur

Das Safe AI Backend basiert auf verschiedenen Azure Diensten. Bei der Auswahl der Dienste haben wir uns auf diejenigen Dienste beschränkt, die die beste Performance und die beste Preis-Leistung bieten, einheitliche Verwaltung und eine gute Integration in die Azure Infrastruktur ermöglichen.

Entitäten

Safe AI Proxy besteht aus verschiedenen Entitäten, die eine unternehmensspezifische Struktur ermöglichen:

Workspaces

Jeder Workspace wird als separate Identität behandelt. Beispiele für Workspace sind z.B. Organisationen, Abteilungen oder Teams. Dies ermöglicht eine genaue Verwaltung und Trennung von Daten und Berechtigungen.

Benutzer

Benutzer sind die Personen, die den Service nutzen. Sie werden durch ihre E-Mail-Adresse identifiziert und sind einem Workspace zugeordnet. So behalten Sie stets den Überblick über die Nutzeraktivitäten.

KI-Modelle

KI-Modelle sind der Kern der Verarbeitung. Safe AI Proxy ermöglicht Ihnen den Einsatz verschiedenster Modelle, die jederzeit ausgetauscht werden können, ohne dass die Anwendungen davon betroffen sind.

Chats

Die Chat-Funktion erlaubt es Benutzern, auf Basis von KI-generierten Antworten zu interagieren. Dies ist besonders nützlich für Kunden-Support und ähnliche Anwendungsfälle.

Completions (Prompts)

Completions sind eine einfache Möglichkeit, um eine Anfrage (Prompt) an das KI-Modell zu stellen. Im Gegensatz zu Chats werden die Antworten nicht in einem Chat-Verlauf gespeichert. Completions sind daher besonders für Automatisierungen und Workflows geeignet.

Knowledge Bases + Einträge

Die Knowledge Bases bieten eine strukturierte Informationsbasis, auf die das KI-Modell bei der Beantwortung von Anfragen zurückgreifen kann. Diese Informationen bleiben unter Ihrer Kontrolle und werden nicht extern verarbeitet. Knowledge Bases können in allen Chats und Prompts verwendet werden.

Tools

Tools sind eine einfache Möglichkeit, um Daten von externen Quellen zu erhalten. So können über Tools z.B. Daten aus einer Datenbank, Dokumentenmanagement-Systemen, CRM-Systemen, etc. abgerufen werden. Tools nutzen gesicherte Aufrufe und können auch das aktuelle Microsoft Account Token nutzen, um als der Benutzer zu agieren, der gerade eingeloggt ist.

Agenten

Agenten bieten eine einfache Möglichkeit, um wiederkehrende Aufgaben mit der KI zu erledigen. Agenten haben ein eigenes System-Prompt, um ihre Aufgaben zu erledigen. Dank der Tools können Agenten auch andere Systeme nutzen und so komplexe Aufgaben über mehrere Systeme hinweg erledigen. Des weiteren haben Agenten auch die Möglichkeit, Knowledge Bases zu verwenden.

Apps

Apps sind Anwendungen in Safe AI Plus, die ein eigene kleine Anwendung mit einer eigenen Oberfläche für Tools darstellen. Kunden können Apps für Ihre ganz spezielle Anwendungsfälle erstellen.

API-Keys

API-Keys bieten zahlreiche Vorteile im Zusammenhang mit der Nutzung von Safe AI Proxy. Unter anderem bieten API-Keys die präzise Steuerung darüber, wer auf die KI-Dienste zugreifen kann. Statt einen globalen API-Schlüssel zu verwenden, werden benutzerspezifische API-Keys für Workspaces generiert. So wird sichergestellt, dass nur autorisierte Benutzer Zugriff auf den Safe AI Proxy und die zugrunde liegenden KI-Modelle haben.

Technische Details

Safe AI Proxy basiert unter anderem auf Azure Functions, Cosmos DB und Azure OpenAI. Die Dienste werden in der Azure Infrastruktur des Kunden installiert und betrieben. Diese und andere Dienste werden, sofern möglich, als Pay-As-You-Go Dienste bereitgestellt. Der Vorteil der Pay-As-You-Go Modelle ist, dass der Kunden die Kosten von der tatsächlichen Nutzung abhängig sind und somit die Kosten optimiert werden können.

Die Entwicklung des Kunden erfolgt test-driven und mit Hilfe von Unit-Tests. Die Entwicklung erfolgt in einem eigenen Repository und wird in der Azure Infrastruktur des Kunden installiert und betrieben.

Alle weiteren Details entnehmen Sie bitte der Dokumentation, der Dokuemntation in der Bereitstellung oder der OpenAPI Dokumentation.